| 【附論文PDF+代碼地址】GNN | 您所在的位置:網站首頁 › 屬羊人和屬蛇人婚配好嗎男 › 【附論文PDF+代碼地址】GNN |

【附論文PDF+代碼地址】GNN

|

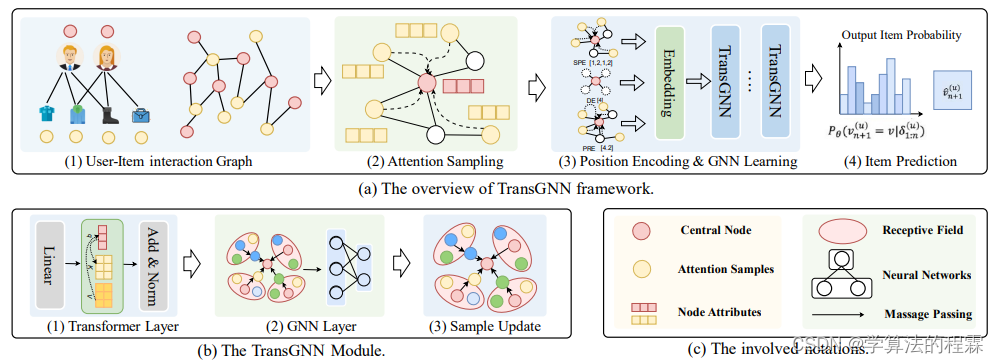

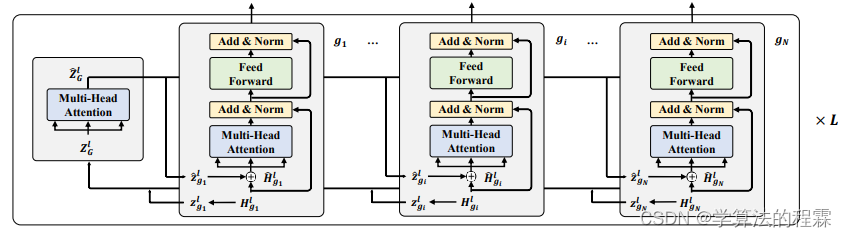

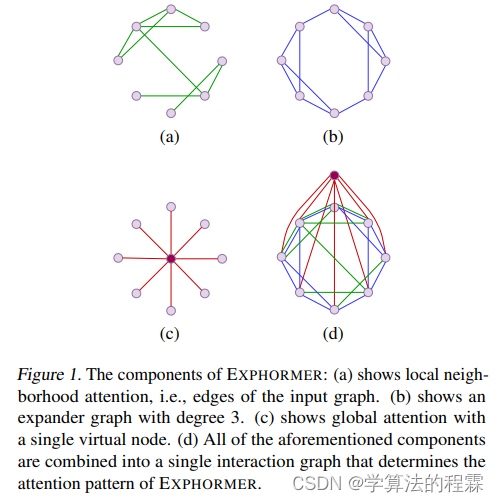

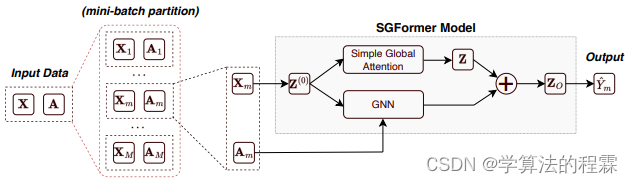

圖神經網絡(GNN)和Transformer的結合是近年來的研究熱點。這類結合不僅能夠讓兩者發(fā)揮各自的優(yōu)勢,還能推動模型的創(chuàng)新,提高處理圖數(shù)據的效率和性能。 具體點講,通過利用Transformer,我們可以擴展GNN的感受野,包括那些距離中心節(jié)點較遠的相關節(jié)點。相對的,GNN也可以幫助Transformer捕捉復雜的圖拓撲信息,并從相鄰區(qū)域高效地聚合相關節(jié)點。 目前,基于Transformer的GNN和圖Transformer是GNN+Transformer的兩大關鍵結合方式,這其中有不少個人認為很值得學習的成果。比如GNN 嵌套 Transformer 模型GraphFormers、僅使用一層全局注意力的簡化圖Transformer模型SGFormer。 本文挑選了18種GNN結合Transformer的最新創(chuàng)新方案和大家分享,并簡單提煉了方法和創(chuàng)新點,配套模型和代碼也都整理了。(看下圖自取即可,全都是無--償分享) 方法:論文提出了TransGNN模型,通過交替使用Transformer和GNN層來相互增強它們的能力。TransGNN利用Transformer層擴大了接受野,并將信息聚合從邊緣中解耦,從而增強了GNN的信息傳遞能力。 為了有效捕捉圖結構信息,作者們設計了細致的位置編碼,并將其集成到GNN層中,以將結構知識編碼到節(jié)點屬性中,從而提高了Transformer在圖上的性能。 為了提高效率,作者們提出了對Transformer進行最相關節(jié)點的采樣,并提出了兩種高效的樣本更新策略,以減少復雜性。 創(chuàng)新點:引入了一種新穎的模型TransGNN,其中Transformer和GNN協(xié)同合作。Transformer擴大了GNN的感受野,而GNN捕捉關鍵的結構信息以增強Transformer的性能。 為了解決復雜性的挑戰(zhàn),作者引入了一種采樣策略以及兩種更新相關樣本的高效方法。 對TransGNN的表達能力和計算復雜度進行了理論分析,揭示了TransGNN相對于具有小額外計算開銷的GNN來說具有更大的潛力。 方法:論文提出了一種名為GraphFormers的模型架構,用于文本圖的表示學習。該模型將GNN和預訓練語言模型相結合,通過將GNN嵌入到語言模型的Transformer層中,將文本編碼和圖聚合融合為一個迭代的流程,從而更準確地理解每個節(jié)點的語義。此外,還引入了漸進學習策略,通過對縱過的數(shù)據和原始數(shù)據進行逐步訓練,增強了模型整合圖信息的能力。 創(chuàng)新點:圖神經網絡嵌套Transformer(GraphFormers):它結合了圖神經網絡(GNNs)和語言模型。在GraphFormers中,GNN組件與語言模型的Transformer層并行設置,允許文本編碼和圖聚合的融合。這種架構能夠從全局角度精確理解每個節(jié)點的語義,從而產生高質量的文本圖表示。 兩階段漸進學習:為了增強模型整合來自圖的信息的能力,作者引入了一種兩階段漸進學習策略。在第一階段,模型在被縱的數(shù)據上進行訓練,其中節(jié)點被隨機污染,迫使模型利用全部輸入節(jié)點。在第二階段,模型在原始數(shù)據上訓練以適應目標分布。這種漸進學習策略提高了GraphFormers的表示質量。 單向圖注意力:為了減少不必要的計算,作者引入了單向圖注意力。只需要中心節(jié)點參考其鄰居,而鄰居節(jié)點保持獨立編碼。這允許緩存和重用現(xiàn)有鄰居的編碼結果,顯著節(jié)省了計算成本。 方法:本文介紹了一種名為EXPHORMER的框架,用于構建強大且可擴展的圖變換器。EXPHORMER采用兩種機制:虛擬全局節(jié)點和擴展圖,這些數(shù)學特性使得圖變換器的復雜度僅與圖的大小成線性關系,并且能夠證明所得到的變換器模型具有理想的理論特性。 創(chuàng)新點:EXPHORMER是一種新的稀疏圖轉換器架構,具有可擴展性和競爭力的準確性。 EXPHORMER基于兩種機制,即虛擬全局節(jié)點和擴展圖,實現(xiàn)了稀疏注意機制。 EXPHORMER的數(shù)學特性包括譜擴展、偽隨機性和稀疏性,使得圖轉換器具有與圖規(guī)模線性復雜度和理想的理論特性。 在GraphGPS框架中使用EXPHORMER可以產生在各種圖數(shù)據集上具有競爭力的實證結果,包括在三個數(shù)據集上的最新結果。 EXPHORMER可以擴展到比以前的圖轉換器架構更大的圖數(shù)據集。 方法:本文提出了一種名為SGFormer的模型,通過一個簡單的全局注意力模型來學習大圖上的節(jié)點表示。該模型具有線性的時間和空間復雜度,能夠高效地處理大規(guī)模圖。 創(chuàng)新點:SGFormer模型: 提出了SGFormer模型,它是一種簡化的圖Transformer模型,只使用了單層單頭的注意力機制。 SGFormer模型具有線性的時間和空間復雜度,能夠有效地處理從數(shù)千到數(shù)十億個節(jié)點的大規(guī)模圖數(shù)據。 SGFormer模型在12個圖數(shù)據集上取得了非常有競爭力的性能,比其他強大的圖神經網絡和最先進的圖Transformer模型都要好。 單層注意力模型的表達能力: 通過將Transformer層與信號去噪問題相連接,證明了單層注意力模型可以產生與多層注意力相同的去噪效果。 單層注意力模型可以實現(xiàn)最速下降,表明它具備足夠的表達能力,能夠學習全局信息。

|

【本文地址】

| 今日新聞 |

| 推薦新聞 |

| 專題文章 |